Belső páros oldalakon - a veszélyes, hogyan lehet megtalálni és semlegesíteni

Hol vannak ismétlődő oldalak?

Hogyan állapítható meg, ha a helyén páros?

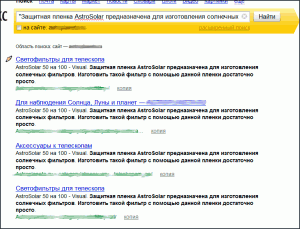

Annak megállapításához, a jelenléte a duplikált helyszínen használhatják Yandex keresést. Ehhez a keresési mezőbe a részletes keresés oldalon adja a szöveg egy részét, a gyanúsított két példányban (szöveg kell beírni idézőjelben), amely meghatározza a vonal „online” a domainnel. Minden olyan oldalt talált lehet tiszta vagy zavaros páros egymást:

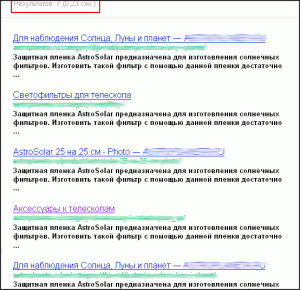

Meghatározza a lehetséges ismétlődések és a Google-keresést. Ehhez a keresési mezőbe írja be a szöveg egy részét az oldalon tesztelik idézetek és szóközzel elválasztva adja meg a keresési - site: examplesite.ru. Példa kérelem ismétlődéseket:

„Hosszú predlozhienie tíz-tizenöt szót az oldalról, ami azt gyanítja, hogy ő egy dupla és szeretné megerősíteni, sem cáfolni ezt a” site: examplesite.ru

Ha vannak ismétlődő, akkor így fog kinézni:

Tiltása irányelv Robots.txt

„Tiltása” irányelv kikapcsolhatja az indexelés oldalak keresési robotok és eltávolítani az adatbázis már indexelt oldalak. Ez a legjobb lehetőség, hogy elleni küzdelem páros olyan esetekben, amikor az ismétlődő oldalak kizárólag az adott könyvtárak, vagy ha az URL-szerkezet lehetővé teszi, hogy közel egy csomó vesz egy szabály.

Például, ha azt szeretnénk, hogy zárjon be minden a találati oldalon az oldalon, hogy vannak a mappában www.examplesite.ru/search/ elég robots.txt felírni szabály:

Egy másik példa. „?” Ha a jel egy munkamenet-azonosítót, akkor megakadályozhatja az indexelő minden olyan oldalakat, amelyeken ez a karakter, egy szabály:

Így lehetséges, hogy megtiltsák indexelés ismétlődések egyértelmű: a nyomtatandó oldalak, a munkamenet-azonosító az oldal, stb Site Search oldalak, stb

Leírás «tiltása» irányelvek alapján Yandex támogatás

Leírás A blokkolási szabály és törli az oldalakat a Google Súgó

Tag rel = kanonikus

Tag rel = kanonikus van, amely jelzi a robotok, hogy melyik oldal a csoport vesz részt kell venniük a keresést. Ez az úgynevezett kanonikus.

Annak érdekében, hogy azokat a robotokat kanonikus oldalon kell regisztrálni az oldalakon a nem-core URL:

Ez módon megszabadulni a másolatok kiváló abban az esetben, úgy elég sok, de zárni őket közös szabályok a robots.txt lehetetlen természete miatt URL.

301 átirányítás

Állítsa átirányítást az egyik oldalról a másikra lehet felírni a .htaccess fájl általában:

Testreszabhatja és tömeges átirányítani a lapok egyik típusról a másikra, de szükséges, hogy ugyanaz volt a URL-szerkezet.

Arról, hogy hogyan kell csinálni a 301-átirányítást Devaka.ru blog.

kreativitás

Vannak olyan esetek, amikor az oldal jeleit mutató fuzzy másolatok, csinálni hasznos információkat tartalmazhat, és távolítsa el őket az index nem akarja. Mi a teendő ebben az esetben? Változás, hozzáadni vagy unikalizirovat tartalmat.

Például, ha a probléma a fuzzy páros miatt keletkeztek túl nagy térfogatú navigációt. meg kell keresni a módját, hogy növelje a tartalom egy része vagy átvágott egység.

Találkoztam már egy csomó más lehetőség belső ismétlődések oldalakon különböző bonyolultságú, de ez nem volt probléma, hogy nem lehet megoldani. A lényeg az, hogy ne késleltesse a kérdés az tart, ameddig a szükséges lapok kiesnek az index, és a helyén fogja veszíteni a forgalom.